shell脚本造数据

Shell 大数据启动脚本

在大数据领域,使用 Shell 脚本来启动各种组件和服务是相当常见的。这些脚本可以简化部署和管理复杂的大数据系统,提高工作效率和可靠性。以下是编写大数据启动脚本的一些建议和最佳实践:

在编写启动脚本之前,首先要明确需要启动的大数据组件和服务。这可能包括 Hadoop、Spark、Hive、HBase、Kafka 等。了解每个组件的启动顺序和依赖关系非常重要。

在编写脚本时,需要考虑以下几点:

- 环境设置:确保脚本能够正确地设置环境变量,包括 Java 路径、Hadoop、Spark 等的安装路径。

- 启动顺序:根据组件之间的依赖关系确定启动顺序,确保先启动必要的服务。

- 参数配置:通过参数传递配置信息,使脚本更加灵活,适应不同的部署环境。

- 错误处理:添加适当的错误处理机制,如检查服务启动状态、日志输出等,以便及时发现和解决问题。

以下是一个简单的示例:

```bash

!/bin/bash

设置环境变量

export JAVA_HOME=/path/to/java

export HADOOP_HOME=/path/to/hadoop

export SPARK_HOME=/path/to/spark

启动 Hadoop

$HADOOP_HOME/sbin/startall.sh

启动 Spark

$SPARK_HOME/sbin/startall.sh

启动其他组件...

```

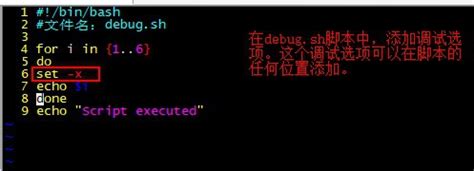

在部署之前,务必对脚本进行充分的测试和调试。确保各个组件能够顺利启动,并且能够正确地处理各种异常情况。

编写文档记录脚本的使用方法和参数配置,以便其他人能够轻松地理解和使用。定期检查和更新脚本,确保与最新的组件版本和环境变化保持兼容。

通过以上步骤,可以编写出高效可靠的大数据启动脚本,帮助简化大数据系统的部署和管理工作。

标签: shell脚本怎么运行 shell脚本开发工具 大数据shell命令 shell脚本造数据 shell脚本打开

相关文章

-

景顺成长,探索中国城市化进程中的绿色发展之路详细阅读

在21世纪的今天,城市化已成为全球范围内不可逆转的趋势,中国,作为世界上人口最多的国家,其城市化进程尤为引人注目,随着经济的快速发展,城市化带来的问题...

2025-10-01 293

-

深度解析,股票000777中核科技的投资价值与未来展望详细阅读

在当今的投资市场中,股票投资无疑是一个热门话题,而在众多股票中,股票代码为000777的中核科技因其独特的行业地位和发展潜力,吸引了众多投资者的目光,...

2025-09-30 343

-

深圳证券交易所交易规则,投资市场的指南针详细阅读

亲爱的读者,想象一下,你正站在一个繁忙的十字路口,四周是熙熙攘攘的人群和川流不息的车辆,每个人都在按照交通规则行事,红灯停,绿灯行,黄灯亮起时,大家会...

2025-09-30 306

-

基金202005,揭秘投资背后的逻辑与策略详细阅读

在投资的世界里,基金是一种备受瞩目的投资工具,它以其多样化的投资组合、专业的管理团队和相对稳定的收益吸引了众多投资者的目光,我们将深入探讨基金2020...

2025-09-30 305

-

探索中国平安行销,策略、实践与未来趋势详细阅读

在当今竞争激烈的市场环境中,行销策略对于企业的成功至关重要,中国平安,作为中国领先的金融服务集团,其行销策略不仅在国内市场上取得了显著成效,也为全球行...

2025-09-29 276

-

深入解析数码视讯股票,投资价值与市场前景详细阅读

在当今数字化时代,数码视讯行业作为信息技术领域的重要组成部分,正逐渐成为投资者关注的焦点,本文将深入探讨数码视讯股票的投资价值与市场前景,帮助投资者更...

2025-09-29 333

-

悦康药业,创新与责任并重,引领健康未来详细阅读

在当今这个快节奏、高压力的社会中,健康成为了人们越来越关注的话题,而在医药行业中,有这样一家企业,它以创新为驱动,以责任为担当,致力于提供高质量的药品...

2025-09-29 277

-

深度解析,定向增发股票背后的资本游戏与投资策略详细阅读

在资本市场的棋盘上,股票的每一次变动都牵动着投资者的神经,定向增发作为一种特殊的融资方式,因其能够为上市公司带来资金的同时,也为投资者提供了新的投资机...

2025-09-29 284